Título: ¿Qué es y por qué el Shadow AI?

Introducción

La inteligencia artificial (IA) ha dejado de ser una tecnología emergente para convertirse en una parte integral de muchas operaciones empresariales en todo el mundo. Desde la automatización de procesos hasta la toma de decisiones basada en datos, la IA promete impulsar la eficiencia, mejorar la experiencia del cliente y generar ventajas competitivas. Sin embargo, este crecimiento acelerado también ha traído consigo fenómenos no regulados que suponen desafíos para las organizaciones, especialmente en términos de seguridad, cumplimiento normativo y governance. Uno de los más significativos y recientes es el «Shadow AI».

Similar al concepto ya conocido del «Shadow IT» —el uso de tecnologías de la información no aprobadas por el área de TI—, el Shadow AI hace referencia al uso de herramientas, modelos o sistemas de inteligencia artificial sin el conocimiento o aprobación de los equipos oficiales de TI o gobernanza de datos. En este artículo exploraremos qué es el Shadow AI, por qué está creciendo de forma acelerada, cuáles son sus principales riesgos y beneficios, y qué estrategias pueden implementar las organizaciones para gestionarlo de forma efectiva.

¿Qué es el Shadow AI?

El término «Shadow AI» se refiere a la implementación o uso de soluciones de inteligencia artificial o machine learning fuera del control o permiso explícito del departamento de TI o de los oficiales de datos de una empresa. Es decir, es el desarrollo, entrenamiento, despliegue o utilización de modelos de IA por parte de empleados o unidades de negocio sin una supervisión formal.

Este fenómeno puede manifestarse de múltiples formas:

– Empleados que utilizan herramientas de IA generativa como ChatGPT, Midjourney o DALL·E para automatizar tareas sin conocimiento del área de TI.

– Departamentos desarrollando modelos predictivos en hojas de cálculo o plataformas cloud como Google Colab sin respaldo o control de datos centralizados.

– Equipos de marketing, recursos humanos u operaciones que adquieren soluciones de IA como SaaS (Software as a Service) sin pasar por los protocolos de evaluación de seguridad de TI.

– Uso de APIs de inteligencia artificial sin sanción corporativa, comprometiendo información sensible o no verificada.

El crecimiento del Shadow AI es impulsado por la accesibilidad creciente a herramientas de IA poderosas que no requieren conocimientos profundos de programación. Esto significa que no solo los científicos de datos o desarrolladores tienen acceso a la IA, sino cualquier empleado con un navegador web. Por consiguiente, la barrera para implementar IA en microprocesos dentro de cada unidad de negocio se ha reducido dramáticamente.

Factores que impulsan el crecimiento del Shadow AI

1. Democratización de la IA

En los últimos años, el acceso a herramientas de IA ha cambiado radicalmente. Plataformas como OpenAI, Hugging Face, Google Vertex AI, entre otras, han hecho que modelos sofisticados sean accesibles desde aplicaciones sencillas. Incluso software corporativo como Microsoft 365 ahora incorpora IA generativa. Esto ha facilitado que profesionales de distintas áreas empresariales puedan experimentar, prototipar o incluso implementar soluciones de IA sin dependencia del área de TI.

2. Agilidad y presión por innovación

Las organizaciones actuales enfrentan presión constante para innovar más rápido y responder con agilidad a los desafíos del mercado. En este contexto, algunos departamentos optan por implementar soluciones de IA por su cuenta como una forma de acelerar resultados sin pasar por los largos procesos de aprobación tradicionales.

3. Falta de gobernanza clara

En muchas empresas, especialmente en etapas tempranas de adopción de IA, no existen políticas claras sobre qué herramientas se pueden usar, cómo se deben gestionar los datos, ni protocolos de supervisión sobre IA. Esta falta de lineamientos alimenta la aparición del Shadow AI.

4. Curiosidad y proactividad de los empleados

Muchos profesionales están motivados a aprender e incorporar nuevas tecnologías para mejorar su trabajo. Esta actitud positiva, aunque valiosa en esencia, puede derivar en la adopción informal de soluciones de IA que escapan de los controles corporativos.

Principales riesgos del Shadow AI

1. Seguridad de la información

El uso de modelos de IA sin supervisión puede comprometer datos sensibles. Por ejemplo, si un empleado introduce datos confidenciales de clientes o estrategias internas en herramientas como ChatGPT, estos datos podrían quedar almacenados en servidores externos cuyos protocolos de seguridad no son conocidos ni controlables por la organización.

2. Cumplimiento normativo

La aplicación no regulada de IA puede violar normativas sobre privacidad de datos como el Reglamento General de Protección de Datos (GDPR) en Europa, la Ley de Privacidad del Consumidor de California (CCPA), o leyes específicas del sector como la HIPAA (en el ámbito de la salud en EE.UU.). Multas, sanciones e incluso demandas podrían derivarse del uso no autorizado de modelos IA.

3. Calidad y confiabilidad de los modelos

Los modelos desarrollados sin supervisión formal pueden carecer de rigor metodológico, procesos de validación, monitoreo o auditorías. Esto puede derivar en resultados sesgados, erróneos o inconsistentes, generando decisiones de negocio de bajo valor o incluso contraproducentes.

4. Fragmentación tecnológica

Cuando equipos crean sus propias soluciones de IA sin coordinación central, se genera una arquitectura tecnológica más difícil de escalar, mantener y asegurar. Esta fragmentación complica la gobernanza integral de los activos de datos, de los modelos y del conocimiento aplicado en IA.

5. Riesgos éticos

El uso irresponsable de modelos generativos o sistemas de clasificación automática puede llevar a prácticas discriminatorias o poco transparentes. Por ejemplo, herramientas no auditadas para filtros de currículums podrían amplificar sesgos de género o raza sin ser detectados.

Beneficios (potenciales) de las iniciativas en sombras

A pesar de los riesgos, es importante notar que la existencia del Shadow AI no parte de una intención perniciosa. En muchos casos, estas iniciativas reflejan una cultura de innovación, proactividad y deseo de mejora continua. Algunos de los beneficios potenciales de estas implementaciones informales incluyen:

– Identificación de nuevos casos de uso para la IA.

– Aceleración de soluciones específicas en contextos urgentes.

– Aprendizaje práctico del personal en inteligencia artificial.

– Mayor involucramiento de distintas áreas de la empresa en la transformación digital.

En este sentido, el desafío para las organizaciones no es simplemente erradicar el Shadow AI, sino encontrar formas de canalizar esa energía innovadora dentro de marcos seguros, éticos y gobernables.

Estrategias para gestionar el Shadow AI

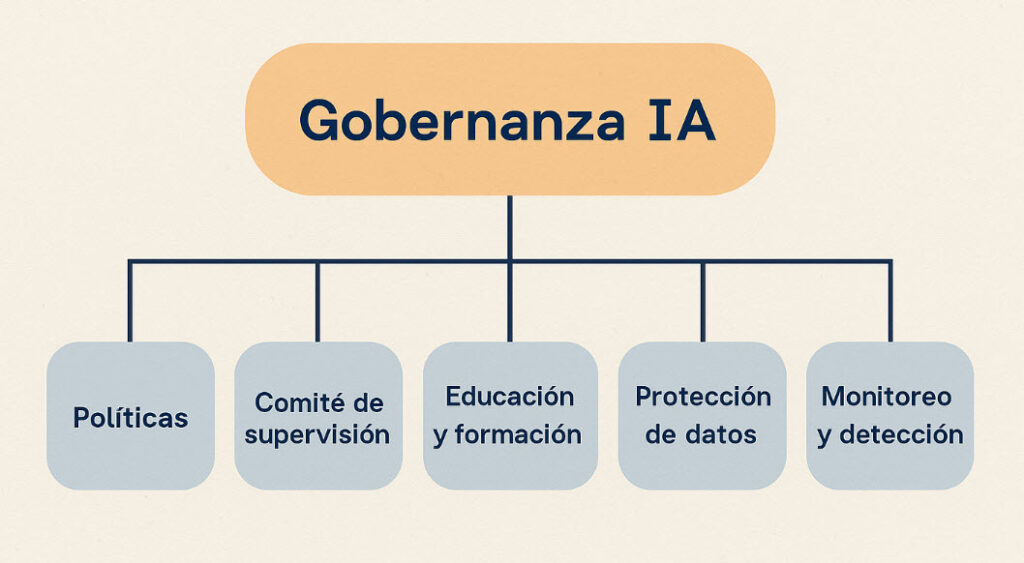

1. Establecer un marco de gobernanza de IA

El primer paso para abordar el Shadow AI es desarrollar una estrategia institucional clara para la adopción y uso de IA. Esta debe incluir políticas sobre qué herramientas y proveedores son aceptables, cómo se deben procesar y proteger los datos, quién es responsable de validar los modelos, cómo se documentan y almacenan los modelos, y cómo se evalúan sus impactos.

2. Inventariar herramientas y modelos existentes

Las organizaciones deben realizar auditorías periódicas para identificar qué modelos de IA están siendo utilizados fuera del control central. Una vez identificados, es importante clasificarlos por nivel de riesgo y valor potencial, de modo de decidir si deben integrarse formalmente, modificarse o eliminarse.

3. Facilitar herramientas oficiales

En lugar de prohibir totalmente el uso de IA, es más efectivo ofrecer herramientas que hayan sido validadas por la organización. Por ejemplo, algunas empresas ofrecen versiones corporativas de herramientas generativas (como ChatGPT Enterprise o Microsoft Copilot) que añaden capas de seguridad y privacidad.

4. Capacitación y concienciación

Una organización preparada para la IA es aquella cuyos empleados entienden no solo cómo usarla, sino también las implicaciones éticas, legales y de seguridad que conlleva. Implementar programas de formación transversales es clave para generar una “cultura de IA” consciente y estratégica.

5. Involucramiento transversal

La gestión del Shadow AI no puede recaer únicamente en el área de TI o legal. Es necesario que departamentos como recursos humanos, marketing, finanzas, auditoría y data science trabajen de forma coordinada en la creación y vigilancia de políticas de IA.

6. Fomentar la innovación “con luz”

En lugar de reprimir completamente el uso autónomo de IA, las organizaciones pueden crear espacios controlados de innovación, donde los equipos pueden experimentar con IA siempre y cuando cumplan ciertos requisitos de transparencia y validación. Estos «laboratorios» fomentan la creatividad sin abandonar la responsabilidad institucional.

7. Uso de soluciones de descubrimiento de IA

Existen herramientas diseñadas para detectar automáticamente modelos de IA en uso dentro de una red corporativa, ayudando a identificar actividades informales y dar visibilidad a las operaciones en sombras.

Casos reales y actualidad

Según informes recientes de Gartner y McKinsey, más del 40% de las organizaciones detectaron que sus empleados estaban utilizando herramientas de IA fuera de la política oficial de tecnología. Además, se ha documentado que muchas empresas han sufrido filtraciones accidentales debido al uso de asistentes de IA generativa por parte de empleados con buenas intenciones pero sin comprensión total de los riesgos.

Empresas como JPMorgan Chase, Samsung o Apple han llegado a restringir parcialmente o totalmente el acceso a herramientas como ChatGPT por preocupaciones relacionadas con el Shadow AI. Por otro lado, firmas tecnológicas como Microsoft y Amazon trabajan activamente en el desarrollo de herramientas empresariales que permitan un uso seguro pero flexible de la IA, precisamente para dar una respuesta estructurada a esta necesidad creciente.

Shadow AI vs. Shadow IT

Aunque ambos fenómenos derivan del uso no autorizado de tecnologías, el Shadow AI presenta desafíos adicionales. Mientras que el Shadow IT puede incluir herramientas de productividad o almacenamiento, el Shadow AI implica el procesamiento automatizado de datos, toma de decisiones asistidas o generación de contenidos, lo que puede tener impactos operativos y éticos mucho más profundos. Esto hace que el Shadow AI requiera políticas aún más específicas y sensibles.

Conclusión

El Shadow AI es ya una realidad en muchas organizaciones. Negarlo o ignorarlo no es una estrategia viable. Si bien puede generar riesgos significativos, también representa una oportunidad para identificar cómo la IA puede mejorar procesos y resultados a lo largo de toda la organización.

La clave reside en reconocer la potencia disruptiva de la IA, pero canalizarla bajo principios de transparencia, seguridad, colaboración y responsabilidad. En un contexto donde la inteligencia artificial será cada vez más ubicua, las organizaciones deben pasar de evitar el Shadow AI a liderar su gestión inteligente y proactiva.

Al final del día, no se trata simplemente de controlar la tecnología, sino de empoderar a las personas para que utilicen la IA de forma ética, responsable y alineada con los objetivos y valores de la organización. Solo así podrán posicionarse con éxito en una era dominada por la inteligencia aumentada.